A discussão sobre ética em IA (inteligência artificial) é mais velha que a tecnologia em si –pelo menos na ficção.

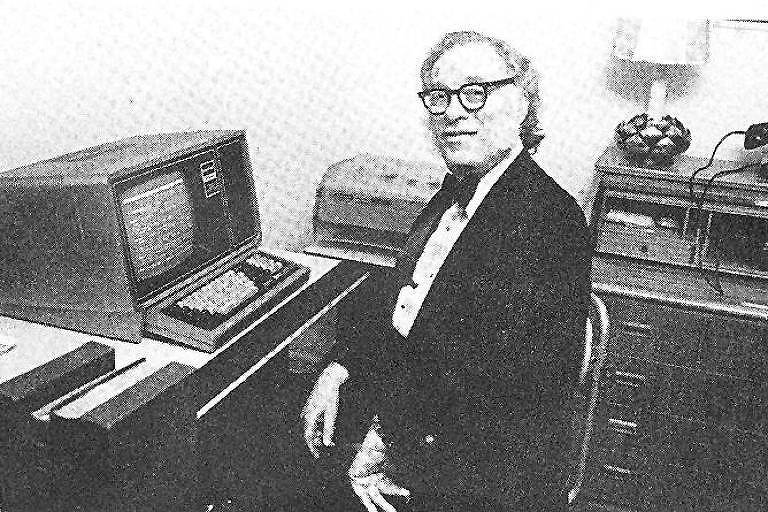

Em 1942, o autor Isaac Asimov escreveu as "três leis da robótica" em um conto que integra o livro "Eu, Robô" (1950). As regras previam a proteção do ser humano.

Apesar de ter explodido recentemente e parecer algo novo, o conceito de IA fora da ficção veio na mesma época em que os escritos de Asimov.

| Carolina Daffara | ||

|

||

As três leis da robótica

- Um robô não pode ferir um ser humano ou, por omissão, permitir que um ser humano sofra algum mal;

- Um robô deve obedecer as ordens que lhe sejam dadas por seres humanos, exceto nos casos em que tais ordens contrariem a Primeira Lei;

- Um robô deve proteger sua própria existência, desde que tal proteção não entre em conflito com a Primeira e a Segunda Leis.

Fonte: "Eu, Robô" (Isaac Asimov, 1950)

-

Formalmente, o termo "inteligência artificial" apareceu pela primeira vez em 1955. Na ocasião, John McCarthy, Marvin Minsky, Nathaniel Rochester e Claude Shannon propuseram um estudo de dois meses a ser realizado na Faculdade Dartmouth, nos EUA. Eles queriam tentar fazer com que máquinas usassem linguagem, formassem conceitos e abstrações, resolvessem problemas "reservados a humanos" e pudessem melhorar a si próprias.

A ideia de IA, ainda sem esse nome, surgiu poucos anos antes. Em 1950, o matemático inglês Alan Turing publicou o artigo "Computing Machinery and Intelligence" ("Computadores e Inteligência").

No texto, ele discutia a possibilidade de inteligência entre máquinas e propôs o "Teste de Turing" (chamado de "Jogo da Imitação" pelo autor), que avalia a capacidade de um equipamento imitar o pensamento de um ser humano.

Turing pontuou que, se uma máquina pudesse imitar um humano em suas capacidades de consciência –entender a linguagem, aprender a partir de uma conversa, lembrar do que foi dito, se comunicar de volta e ter senso comum–, significaria que o computador em si seria consciente.

O jogo consiste em fazer perguntas a uma pessoa e a um computador, sem saber qual é qual. A partir das respostas, o interrogador tenta identificar o humano e a máquina.

Muitas críticas foram feitas a esse modelo. Entre elas não avaliar capacidade criativa e apresentar uma concepção limitada do que é a inteligência humana.

A expectativa de Turing era de que o teste fosse superado antes de 2000. Até hoje, no entanto, nenhum computador venceu o jogo, e ele permanece como um dos objetivos para pesquisadores em IA. Um dos principais desafios é o interrogador estar ciente de que uma das partes entrevistadas é uma máquina. Versões mais simples do jogo, sem a pessoa saber que conversa com um computador, já foram superadas.

Os jogos continuaram a fazer parte do desenvolvimento da IA ao longo dos anos.

Um dos marcos mais famosos na história dessa tecnologia veio em 1997, quando um computador da IBM, chamado Deep Blue, derrotou o enxadrista que então detinha o título de campeão mundial, Garry Kasparov. Em 2016, outro marco: a AlphaGo (da Google) derrotou o campeão mundial do jogo de tabuleiro japonês Go, considerado mais complexo que o xadrez.

As vitórias certamente chamaram a atenção para a tecnologia, mas não demonstram grandes avanços em IA.

As abordagens usadas para que computadores pudessem jogar xadrez foram criadas em 1950 pelo matemático americano Claude Shannon. O que mudou nesses 47 anos foi a potência dos computadores e sua capacidade de processar informações.

Shannon propôs duas formas de um computador jogar xadrez. A primeira usa o que especialistas chamam de força bruta. São simuladas várias (milhares ou milhões) de possibilidades a cada jogada, e a máquina escolhe a que entende ser a melhor, sem pensar numa estratégia mais ampla.

A outra consistia em analisar um número menor de movimentos possíveis, pensando numa estratégia. Nos anos 50 e 60, esse modelo, apesar de mais complexo, era mais comum devido ao que os computadores da época permitiam –já que menos jogadas eram testadas.

Na vitória sobre Kasparov, o sistema da IBM usou a primeira abordagem. O Deep Blue avaliava cerca de 200 milhões de posições por segundo.

"Quando a poeira [da vitória de Kasparov] baixou, pesquisadores perceberam que criar um campeão artificial de xadrez não ensina muito", escreveu François Chollet, pesquisador de inteligência artificial do Google, em artigo científico publicado em novembro.

"Eles aprenderam a fazer uma IA que jogava xadrez, mas nem esse conhecimento nem a IA construída serve pra muita coisa além de participar de jogos de tabuleiro semelhantes", completa Chollet.

No caso do Go, Chollet diz que ainda não encontrou aplicação para a tecnologia empregada na vitória.

INVERNOS NA IA E MACHINE LEARNING

As boas ideias no papel, mas inaplicáveis na prática, contribuíram para uma grande quebra de expectativa em torno da IA.

Duas vezes na história ocorreram escanteios dessa tecnologia, em períodos batizados de "invernos" –referência ao "inverno nuclear", fenômeno hipotético de resfriamento climático global após uma guerra nuclear.

Decepções com a IA, e seus repetidos fracassos em levar para a prática boas ideias do papel, fez também com que governos que financiavam pesquisas na área, como o americano e o britânico, cortassem investimentos.

Nesse inverno, pesquisadores começaram a adotar outros nomes para a tecnologia a fim de tentar conseguir verbas. Apareceram termos como "machine learning" ("aprendizado de máquina") ou "computação avançada".

Nos anos 70, a IA voltou a ganhar alguma tração com os chamados "sistemas especialistas". Eles eram programas de computador focados em imitar um ser humano expert em um assunto para realizar uma atividade. Programas especializados em analisar estruturas químicas, diagnóstico de doenças e outros.

Eles criaram muita expectativa, e alguns deles chegaram a sair do papel, mas o trabalho para criar esses programas era muito grande. Além disso, não era possível entender como a máquina pensava e tirava conclusões –grosso modo, funcionava como uma caixa-preta.

"As pessoas ficaram tão desiludidas que se afastaram da área", diz Kanta Dihal, pesquisadora da Universidade de Cambridge.